העולם כיום מלא בהאקרים שלא היו נעשים כאלה אילולא ה-GenAI

מפתה לחשוב על בינה מלאכותית יוצרת (GenAI) בתור כלי מהפכני, שמסייע לנו לייצר קוד, לכתוב תוכן ולנהל את הכספים שלנו ביעילות. כל זה נכון כמובן, אך לצד הפוטנציאל העצום הגלום ב-AI, אי-אפשר להתעלם מהשימוש הגובר של טכנולוגיה זו על ידי גורמים זדוניים. חשוב לחדד: לא מדובר רק בעוד כלי בארגז הכלים שעומד לרשות ההאקר המצוי, אלא ביצירת גל איומים חדש בסוגו ובהיקפו. למעשה, כמי שעוסק כבר שנים במניעת הונאות פיננסיות - ניתן לקבוע שהעולם כיום מלא בהאקרים שאפילו לא היו נעשים כאלה אילולא ה-GenAI.

הגורם הראשון שמוביל להרחבת מעגל איומי הסייבר היא הדמוקרטיזציה של הפשע המקוון. כלי AI גנרטיביים מורידים משמעותית את סף הכניסה לעולם ההאקינג. בעבר זה היה מועדון סגור למומחי בעלי ידע וכישורים טכניים מתקדמים כדי להוציא לפועל מתקפה. כיום גם מי שלא השלים קורס תכנות אחד בחייו יכול להשתמש בלי GenAI כדי לייצר קוד זדוני יש מאין, לאתר חולשות אבטחה פוטנציאליות בארגונים, ואפילו לבנות מתקפה מתוחכמת בהתאמה אישית למטרה ספציפית. הכלים הללו הופכים כל אדם עם חיבור אינטרנט לפוגע סייבר בפוטנציה.

לא מדובר רק באיום תיאורטי, כמובן: אנו עדים לזינוק משמעותי בנפח וברמת התחכום של המתקפות על חברות וארגונים. טכנולוגיית ה-AI מאפשרת ליצור אוטומציה של המתקפות, מה שמגביר את היקפן כמותן ומהירות הוצאתן לפועל באופן חסר תקדים. במקביל לעלייה בהיקף, גם איכות המתקפות נמצאת בעלייה מתמדת: המתקפות הופכות מתוחכמות וקשות יותר לאיתור, והודעות הפישינג שנועדו לפתות משתמש ללחוץ על לינק או להזין סיסמא נכתבות בצורה כמעט מושלמת – ללא שגיאות כתיב או דקדוק – מה שמגביר משמעותית את שיעור ההצלחה שלהן.

כל מי ששיחק קצת עם ChatGPT יודע שמדי פעם כלי AI מספקים תוצרים שגויים למדי, ולמעשה מנותקים מהמציאות. המונח הרשמי של תוצאות כאלה הן Hallucinations ("חזיונות שווא"). התוקפים יודעים לנצל לרעה את הטעויות הללו בכלי AI שחברות מעמידות לרשות הציבור - כמו למשל צ'אטבוט לשירות לקוחות. אותם גליצ'ים במודל ופלטים לא צפויים משמשים את ההאקר לביצוע מניפולציה ולאתר דרכי תקיפות חדשות וייחודיות.

כלי AI גנרטיביים מפתחים גם יכולת שכנוע משופרת באמצעות טכנולוגיות כמו Deepfakes. יצירת תכני דיפ-פייק באמצעות זיוף קול, תמונה או סרטון וידאו של אדם מסוים באיכות שכמעט אינה נופלת מהמקור, עומדות בבסיס מתקפות הנדסה חברתית (Social Engineering) והופכות אותה לאמינות ומסוכנות יותר מאי פעם. לדוגמה, הודעה קולית מזויפת שבאה כביכול מסמנכ"ל הכספים עשויה להוביל בקלות להעברת כספים או חשיפת מידע רגיש.

איפה כל זה שם אותנו? אנחנו נמצאים בעיצומו של מירוץ חימוש מול גורמי הפשע. השימוש המאסיבי ב-AI על ידי התוקפים מחייב את מפתחי ומהנדסי אבטחת המידע להתמודד עם אתגרים מורכבים יותר מבעבר. כלי ההגנה מבוססי AI חייבים להיות כל הזמן צעד אחד לפני הכלים ההתקפיים. הדבר מחייב מהנדסים סקרנים, בעלי הבנה עמוקה של הבעיה – לא רק של הקוד – ועם יכולת לתקשר רעיונות בבהירות כדי להוביל פתרונות.

ארגונים רבים היום נוטים לחשוב שהמענה לאיומי הסייבר בעידן ה-AI הוא טכנולוגי. ברור ששימוש בכלי AI הוא הבסיס להבנת והכשלת תוקפים, אבל בסופו של דבר AI היא מכונה. מכונה מדהימה שיודעת לייצר קוד - ואפילו קוד טוב - אבל כמו כל מכונה, היא חייבת השגחה אנושית.

למה הדבר דומה? הטכנולוגיה כיום מאפשרת למטוסי נוסעים להטיס את המטוס לגמרי לבד, ואפילו להנחית אותו בשלום ללא מגע יד אדם. ועדיין, אף חברת תעופה בעולם עדיין לא ויתרה על טייס בקוקפיט שישגיח על המכשירים. אחד המונחים השגורים לתיאור התופעה הזו היא Human in the Loop. אני חושב שנכון יותר לכנותה: Expert in the loop. אין תחליף לבקרה אנושית של מומחי סייבר שמכירים לא רק את כלי ה-AI החדשניים ביותר - אלא גם יועדים להיכנס לראש של ההאקר ולחשוב כמוהו. אז בשעה שמהפכת ה-AI מייתרת חלק מהכישורים הטכניים שבעבר היו לחם חוקם של מפתחים, היא מחדדת את הצורך ביתרון האנושי של מי שיודע לנהל את הכלים האלה - אפילו אם הוא צעיר שרק עכשיו סיים את התואר באוניברסיטה.

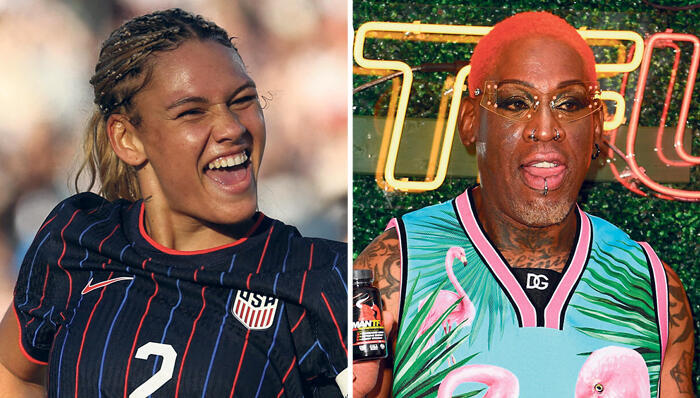

אורי וינשטיין הוא VP Trust and Safety בחברת הפינטק Intuit