כשהמציאות מפסיקה להיות אמיתית: אבטחת סייבר בעידן הסוכנים החכמים

בינואר 2024, עובד במחלקת הכספים של חברת ההנדסה הבריטית Arup קיבל הודעה ממי שנחזה להיות סמנכ"ל הכספים של החברה. ההודעה עסקה ברכישה סודית ודרשה העברת כספים מיידית. כדי להפיג כל חשש, התקיימה שיחת וידאו שבה העובד ראה ושמע את מי שנראה כסמנכ"ל הכספים, מלווה במספר בכירים נוספים בחברה וכולם אישרו את הפעולה פה אחד.

העובד, משוכנע לחלוטין באמיתות הסיטואציה, ביצע 15 העברות נפרדות בסך כולל של 25 מיליון דולר לחשבונות בהונג קונג. רק מאוחר יותר התבררה האמת המבהילה: העובד היה האדם האמיתי היחיד בשיחה. כל שאר המשתתפים היו Deepfakes דמויות מלאכותיות שנוצרו בבינה מלאכותית, עם תנועות פנים מסונכרנות וקולות ריאליסטיים להחריד.

זהו אינו תרחיש מתוך סרט מדע בדיוני, זו המציאות הטכנולוגית והביטחונית שלנו. ברבעון הראשון של 2025 בלבד, הונאות מבוססות Deepfake גרמו להפסדים של למעלה מ-200 מיליון דולר ברחבי העולם, כאשר מתקפת זהות כזו מתרחשת בממוצע כל חמש דקות. למעשה, מאז 2023 נרשמה עלייה בלתי נתפסת של 3,000% בהיקף ההונאות הללו.

הסיבה המרכזית לזינוק היא הנגישות. הטכנולוגיה הפכה לזמינה באופן מסוכן: כיום, כדי ליצור שכפול קולי ברמה של 85% דמיון, נדרשות לתוקף רק 3 עד 5 שניות של הקלטה מקורית. עם יותר מ-350 כלים הזמינים לכל דורש ובעלות של פחות מדולר, ניתן להפיק קול משכנע תוך פחות מ-20 דקות.

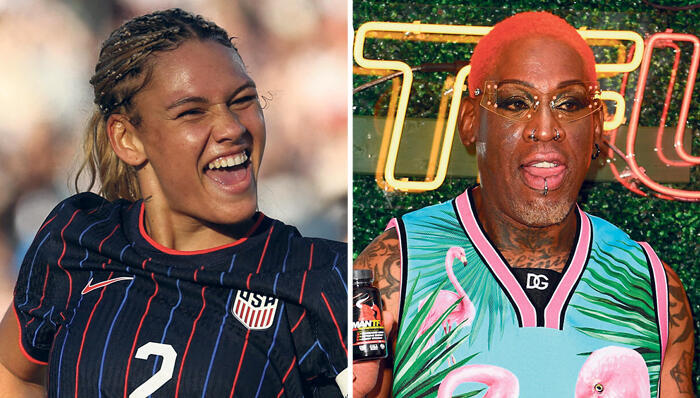

חומרי הגלם נמצאים בכל מקום, שיחות ועידה, פודקאסטים, סרטוני יוטיוב ואפילו הודעות קוליות בוואטס-אפ. אפילו ענקיות כמו פרארי כמעט נפלו בפח, כשביולי 2024 תוקפים התחזו למנכ"ל החברה וחיקו את המבטא האיטלקי הייחודי שלו בדיוק רב. רק ערנות של מנהל ששאל שאלת אימות אישית, מנעה את האסון ברגע האחרון.

מרכזי שירות הלקוחות נמצאים כיום בחזית המאבק הזה. דוחות עדכניים חושפים כי אחת מכל 106 שיחות מראה סימנים של מניפולציה קולית, וההפסדים בתחום זה נאמדים במיליארדי דולרים. התחזיות של גרטנר קודרות: עד 2026, כשליש מהארגונים לא יוכלו עוד לסמוך על פתרונות אימות זהות סטנדרטיים. ולמרות זאת, הרוב המוחלט של החברות עדיין לא נקט צעדים משמעותיים להגנה. אך בעוד העולם מתמקד בסכנות המגיעות מבחוץ, הסכנה האמיתית והמתוחכמת יותר מסתתרת דווקא בתוך הארגון פנימה. מעטים מבינים שסוכני ה-AI , שאנו מטמיעים בהתלהבות בתוך המערכות שלנו, הפכו לווקטור תקיפה חדש ומסוכן.

הבעיה מחריפה עם אימוץ סטנדרטים חדשים כמו פרוטוקול MCP של Anthropic. הפרוטוקול, שנועד לחבר בין מודלי שפה לכלים חיצוניים, יצר למעשה דלתות אחוריות קריטיות. פגיעויות אבטחה שהתגלו לאחרונה אפשרו לתוקפים להריץ קוד מרחוק ולהשתלט על מערכות הארגון דרך הדפדפן. הסכנות הן מערכתיות: מהזרקת פקודות ועד גניבת טוקנים של OAuth, המעניקים לתוקף גישה מתמשכת למערכת גם לאחר החלפת סיסמאות.

האתגר הגדול ביותר הוא אולי ה-"Prompt Injection" – היכולת לתמרן את סוכן ה-AI באמצעות הוראות זדוניות המוסתרות בתוך מסמכים תמימים לכאורה, דפי אינטרנט או אפילו תווי יוניקוד בלתי נראים. דמיינו תרחיש שבו פרומפט זדוני המוטמע בכרטיס Jira פשוט, מעובד על ידי כלי הפיתוח ומחלץ סודות ומפתחות API מתוך הקוד הארגוני. במערכות רב-סוכניות המצב מורכב אף יותר: תקיפה של סוכן אחד הופכת אותו למשתף פעולה מבולבל, המעביר מידע שגוי לשאר הסוכנים ומרעיל את קבלת ההחלטות של המערכת כולה.

אז מה עושים? הפתרון דורש שינוי תפיסתי. עלינו לאמץ גישה של MCP Firewall (חומת אש לכלים) ועקרונות ה Zero Trust (אפס אמון) חייבים להתרחב גם לסוכני ה-AI שלנו. אבטחה מסורתית מניחה שהרשת הפנימית בטוחה, אבל סוכני AI פועלים ללא גבולות ומתחברים לשירותים חיצוניים ללא הרף. פתרונות חדשים בשוק, המציעים שערי אבטחה ומערכות בקרה, מאפשרים לסנן פרמטרים זדוניים ולנטר בזמן אמת כל פעולה של הסוכן, החל מהפרומפט ועד להחלטה הסופית.

העתיד כבר כאן, והוא מחייב אותנו לעירנות שיא. אבטחת מידע בעידן הזה היא כבר לא רק הגנה על תשתיות או נתונים, היא הגנה על האמת עצמה, על התהליכים הלומדים ועל האמון הבסיסי בארגון. בעידן שבו הבינה המלאכותית היא גם שומר הסף וגם הפורץ הפוטנציאלי, חובתנו להיות תמיד צעד אחד לפני האלגוריתם הבא.

שלומי גוטמן הוא סמנכ"ל טכנולוגיות בחברת Voicenter