מי שומר על השומר? כש-AI הוא שומר הסף

החשיפה על כך שכ-10% מהכנסות מטא מקורן במודעות הונאה, הימורים ומוצרים אסורים איננה עוד “סקופ טכנולוגי”. זהו תמרור אזהרה לכל מי שבונה מוצר דיגיטלי, מנהל תקציבי פרסום, או מוודא הגנות סייבר בארגון. בעולם שבו אלגוריתמים קובעים מה נראה, למי, ובאיזה מחיר, הבינה המלאכותית הופכת בפועל לשומרת הסף של האתיקה. השאלה היא לא רק האם היא עושה את זה טוב, אלא מי מגדיר לה מהו “טוב"?

אני רואה מדי יום את הפער בין הרצוי למצוי. מצד אחד, AI מאפשר דיוק, סקייל ומהירות שלא הכרנו. מצד שני, כשהמודלים אופטימיים לקליק, ל-ROAS או להכנסה, הם ימצאו את דרכם גם לתוכן שאנחנו לא רוצים לראות. לא כי הם “רעים”, כי זו פונקציית המטרה שנתנו להם. אם לא נכניס לתוך הפונקציה אתיקה, בטיחות ואחריות, נקבל בדיוק את מה שביקשנו: מיקסום הכנסות, גם כשזה עולה לנו באמון הציבור, בבטיחות משתמשים ובהפסדים אמיתיים לכיס של אנשים.

כאן מתחילה האחריות הניהולית. אתיקה בדיגיטל היא לא סעיף “תדמית” ולא הערה בסוף המצגת. זו ארכיטקטורה. כמו שאי אפשר להוסיף אבטחה לתוכנה ביום ההשקה, אי אפשר להדביק אתיקה למודל אחרי שהושרש לכל שרשרת הערך. צריך לתכנן אותה.

שלוש חובות שמוטלות על הפלטפורמות בעידן ה-AI

1. אתיקה כבר בשלב העיצוב. Ethics by Design איננו סלוגן. הוא מחייב תרגום טכני: פונקציות מטרה שמשקללות סיכון, ספי פעולה שמרניים כברירת מחדל, ו “Revenue Kill-Switch” לקטגוריות מסוכנות. כמו שיש לנו PRD ו ADR צריך גם ERD Ethical בלי זה, האלגוריתם ימשיך למקסם את מה שמדדת לו.

2. מעקה בטיחות בזמן אמת. כשיש ספק, אין ספק. אלגוריתמים צריכים לפעול מוקדם תחת אי ודאות, ולהסלים מהר לשיפוט אנושי. זה אומר שינוי אמיתי במכרזי פרסום: לא “לקנוס” מפרסם חשוד ולשמר הכנסה, אלא להדיח אותו מהתחרות. זה גם אומר מודלי זיהוי לפרסונות עברייניות, ניטור מסלולי נחיתה, ו-negative lists שחיות ומתעדכנות בקצב הפיד, לא ברבעון.

3. פיקוח ושקיפות חיצוניים. אני תומך בתקינה מחייבת שתכלול:

1. דו"חות רבעוניים של Scam Exposure עם מדדים אחידים וברורים.

2. מנגנון Clawback להשבת הכנסות מפרסום שהוגדר כהונאה.

3. API פתוח לחוקרים ולמותגים לקבלת מדדי Brand Safety בזמן אמת.

כמו ש-SBOM הפך לסטנדרט בתוכנה, הגיע הזמן ל Ad-SBOM שיתעד את מרכיבי המודעה, שרשרת השותפים והמסלול הדיגיטלי שלה מתחילתו ועד סופו.

מה התפקיד שלנו, כמנהלים בישראל

אנחנו לא צריכים להמתין לרגולטור האירופי או האמריקאי. אפשר לקבוע סטנדרט מקומי של אחריות, ולדרוש אותו כספקים וכמפרסמים.

• מפרסמים: להכניס להסכמי מדיה SLA של בטיחות, החזר אוטומטי על חשיפות להונאה, ותנאי סף לספקי אנטי-פרוד חיצוניים. תדרשו דשבורד שקוף, בזמן אמת, של חסימות, ערעורים ושיעור הישנות.

• ארגונים: להקים ועדת AI Risk בדרג הנהלה, עם בעלות חוצה שיווק, אבטחה ומשפטית. לתת לה סמכות לעצור פעילות שאינה אתית, גם אם היא “רווחית”.

• מוצר וטכנולוגיה: להגדיר ERD כחלק מה PRD ולמדוד MTTR של סיכוני תוכן כמו שמודדים פרפורמנס, ולחייב שערים אתיים ב CI/CD של מודלים ואלגוריתמים.

מניסיוני, כשמיישמים עקרונות אלה בפועל קורים שני דברים. ראשית, העקומה העסקית לא קורסת אלא מתייצבת. ארגונים מגלים שהכנסה “אדומה” פוגעת במותג יותר ממה שהיא מוסיפה לשורה התחתונה. שנית, אנשים חוזרים לתת אמון. שקיפות ופעולה מוקדמת בונות הון תדמיתי שלא קונים בכסף.

יש רגעים שבהם מנהיגות דיגיטלית נבחנת לא ביכולות האופטימיזציה שלה, אלא ביכולת להגיד “לא”. לא להכנסה שמגיעה מהימורים על חשבון משתמשים פגיעים. לא לקמפיין אפור שמוסיף 3% המרה ומוחק 30% אמון. לא למודל שלא יודע להסביר למה הוא מקדם מודעה מסוימת. “לא” כזה הוא כן גדול ללקוחות, לעובדים ולחברה שאתם רוצים להיות.

הטכנולוגיה תמשיך לרוץ. גם ההונאות. השאלה היא מי ירוץ עם המצפון. האחריות מוטלת על הפלטפורמות, על הרגולטורים, וגם עלינו מקבלי ההחלטות בארגונים שמזינים את המכונה. אם נעצב את האתיקה כמו שאנחנו מעצבים מוצר, נרוויח לא רק משתמשים בטוחים יותר, אלא תעשייה יציבה ובת קיימא.

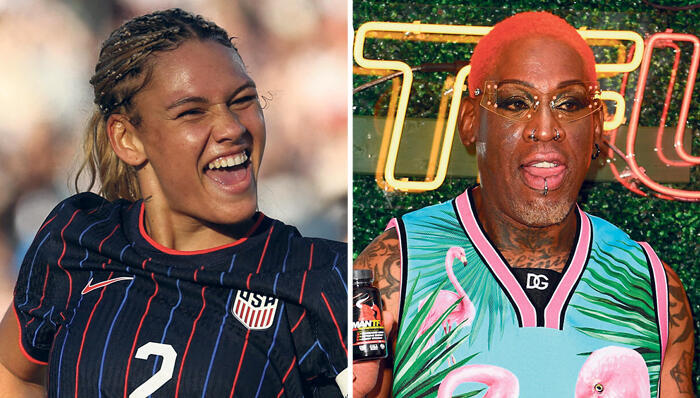

רועי דימניק הוא מנכ"ל SQlink Digital