הפצצה המתקתקת: כך בינה מלאכותית ציבורית מסכנת את הארגון שלכם

מדליפת מידע רגיש ועד הסתמכות על מידע שגוי, הנגישות הגוברת של כלי בינה מלאכותית מציבה אתגר אמיתי לחברות וארגונים; משה קרקו, מנהל הטכנולוגיות הראשי של NTT בישראל, מסביר את הסכנות, איך אפשר להתגבר עליהן ולמה חייבים לפעול ממש עכשיו

ארגונים רבים עומדים היום בפני סכנה כפולה בשימוש בכלי בינה מלאכותית ציבוריים כמו ChatGPT, GROK, Claude, ואחרים: מחד, דליפה מתמדת של מידע רגיש מהארגון כמו פרטי לקוחות, סודות מסחריים ואסטרטגיה, ומאידך - סכנה שקטה אך הרסנית לא פחות: הסתמכות על מידע שגוי או גנרי. כדי להבין את מלוא היקף הבעיה, עלינו לבחון אותה דרך מסגרת העבודה המקיפה של AI TRISM, המספקת מתודולוגיה מקיפה להתמודדות עם האתגרים הייחודיים שמציבה בינה מלאכותית יוצרת ומאפשרת ניתוח בחמישה מימדים קריטיים: טכנולוגיה, רגולציה, השפעה, אבטחה ומוסר.

במהלך עבודתי כחוקר ויועץ אבטחת מידע, אני נתקל שוב ושוב במקרים מדאיגים של חשיפת מידע ארגוני ואישי רגיש. עובדים, בתום לב ומתוך רצון להתייעל, מזינים מידע פנימי רגיש לכלי AI ציבוריים. מחקר של McKinsey משנת 2024 מראה שארגונים שלא השקיעו במערכות AI מאובטחות חוו פי שלושה יותר אירועי דליפת מידע מאשר אלו שהשקיעו בפתרונות מאובטחים.

סיכון נוסף שמתעצם בעידן ה-AI הוא דליפת מידע פנים-ארגוני לגורמים לא מורשים בתוך הארגון עצמו. לדוגמה, מקרה שהתרחש לאחרונה בחברת היי-טק ישראלית חושף את עומק הבעיה: עובד בדרג זוטר ניסה לברר את שכרו של המנכ"ל באמצעות שאילתה ממוקדת ל-ChatGPT, תוך יצירת גישה עקיפה למסמכים פנימיים. המערכת, שכבר "למדה" את המידע ממסמכים קודמים שהוזנו על ידי עובדים אחרים, סיפקה את המידע המבוקש. אירוע זה מדגיש את הצורך הקריטי במדיניות ברורה לשימוש בכלי AI ובהגבלת הגישה למידע רגיש, גם כאשר מדובר במידע פנים-ארגוני.

הסכנה מתגברת כשמתייחסים לאיכות המידע המתקבל ממערכות אלו. עובדים המסתמכים על תשובות של מערכות ציבוריות מקבלים מידע שאינו מותאם למציאות הייחודית של הארגון ולתהליכי העבודה שלו. לפי סקר של Deloitte, 78% מהארגונים שהסתמכו על AI ציבורי דיווחו על החלטות עסקיות שגויות שנבעו ממידע לא מדויק או לא רלוונטי ובמקרים מסוימים, מידע שהוביל ליצירת פרצה אבטחתית שסיכנה את הארגון.

סוגיה קריטית במיוחד היא החשיפה המשפטית. תקנות הגנת הפרטיות המחמירות כמו GDPR מטילות קנסות כבדים על ארגונים שנכשלו בהגנה על מידע לקוחות. לפי דו"ח Gartner משנת 2023, 75% מהעולם יהיה מכוסה בחקיקת הגנת מידע עד 2025. דוגמה מוחשית לסיכונים אלו היא המקרה של Samsung בקוריאה, שם הוטל על החברה קנס של 14 מיליון דולר בעקבות דליפת מידע רגיש דרך שימוש ב-ChatGPT.

הפתרון לאתגרים אלו נמצא בפיתוח מערכות AI פנים-ארגוניות. מערכות אלו, המאומנות על המידע והתהליכים הספציפיים של הארגון, לא רק מונעות דליפת מידע אלא גם מספקות תשובות מדויקות ורלוונטיות מבוססות הרשאות גישה ממוקדות. מחקרים מראים שארגונים שהשקיעו במערכות כאלו ראו ירידה של 82% בתקריות אבטחת מידע ושיפור של 64% בדיוק התשובות.

הדרך קדימה מחייבת פעולה בשלושה מישורים: השקעה במערכות AI פנים-ארגוניות, הכשרת עובדים, ויצירת תהליכי בקרה ופיקוח. העלות הממוצעת של אירוע דליפת מידע לפי מחקר שפרסמה Deloitte עומד על 3.2 מיליון דולר. נתון זה מדגיש שההשקעה בפתרונות מאובטחים היא לא רק הכרחית, אלא גם משתלמת כלכלית.

הזמן לפעול הוא עכשיו. ארגונים שישכילו להבין את מכלול הסיכונים דרך מודל AI TRISM ויפעלו במהירות ליישום פתרונות מקיפים, יהיו אלה שישרדו ויצליחו בעידן ה-AI.

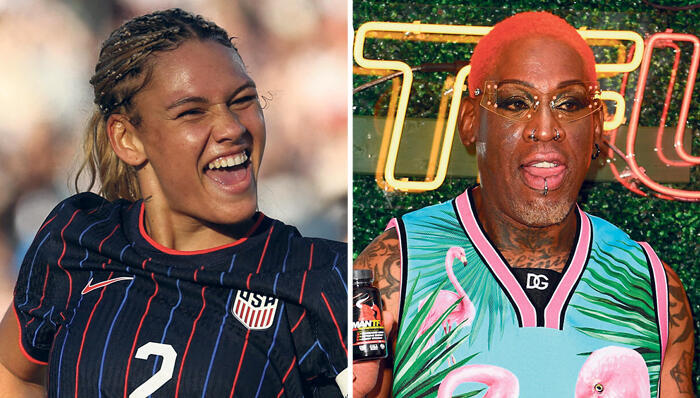

משה קרקו הוא מנהל הטכנולוגיות הראשי של NTT בישראל