טייס בדואי שטוף זימה: כך תגלו מה בינה מלאכותית חושבת עליכם אישית

מיצג אמנותי חדש מנסה להעביר את הבעיה שבהטיה המובנית שבתוכנות זיהוי פנים המוני וקיטלוג אוטומטי של אנשים. בעזרת לינק פשוט תוכלו לראות אם התוכנה רואה אתכם כטייסי קרב, עבריינים, חולי נפש, בני אצולה או מהפכנים מסוכנים

אלגוריתמים חכמים משפיעים על חיינו בשיעור שמתגבר בהתמדה: הם שקובעים מה נראה בפיד של פייסבוק, הם שעוזרים לרופא לגלות שאיזה טשטוש שהופיע בבדיקת רנטגן הוא בעצם סימן למחלה מסוכנת, והם שאומרים לחברות ביטוח אילו עמלות לגבות מאיתנו. ואולם, ההשפעה הכי ישירה שלהם היא ברמת ראיית המכונה: תוכנות שמסתכלות על הפרצוף שלנו דרך מצלמות רחוב, ומקטלגות אותנו. זה נעשה באופן נרחב ביותר בסין, אך גם בארצות הברית, בריטניה ודמוקרטיות אחרות. תוכנות שמביטות בנו ופוסקות אם אנחנו סיכון ביטחוני, אם אנחנו משתייכים לקבוצה שצריך לנטר, אם אנחנו מהטובים או מהרעים. ובאופן אבסורדי, התוכנות הללו לא מדויקות בעליל; ניסוי שנערך בבריטניה בשנה שעברה גילה שיעור טעות של 92%, ובדיקה מארה"ב מצאה כשל של 100%. ועדיין, התוכנות הללו נמצאות בשימוש הולך וגובר, עם כל הבעיות שלהן. מה הן חושבות עליך, באופן אישי, ועד כמה חמורה ההטיה שלהן?

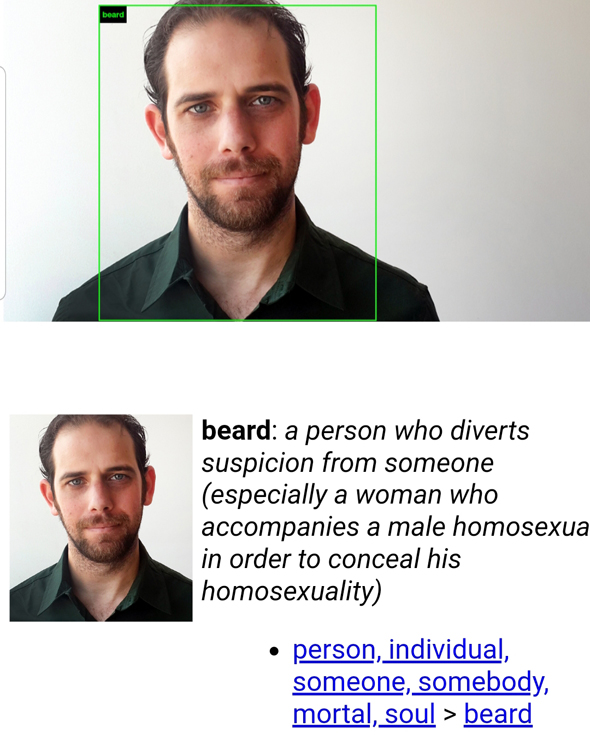

האמנים קייט קרופורד וטרוור פגלן מצאו דרך יצירתית להעלות את הנושא למודעות: הם פשוט חיברו את אלגוריתם קיטלוג התמונות של מאגר ImageNet למנוע הזנת תמונות חיצוני. הרעיון פשוט - אתם מזינים תמונה, בין אם בלינק ובין אם כקובץ, והאלגוריתם מקטלג אתכם לפי הקטגוריות שהוגדרו לו, וקצת בינת מכונה. התוצאות, במבט ראשון, משעשעות: למשל, כשהצגתי את התמונה הזאת, החליטה התוכנה שאני Beard, כלומר אדם שמסייע למישהו אחר להסתיר את הנטיה המינית שלו ע"י התחזות לבן זוג שלו. מדובר בסיטואציה חברתית מורכבת ומאוד ספציפית, ולא ברור איך חיברה התוכנה אותה אלי רק על בסיס התמונה.

| |||

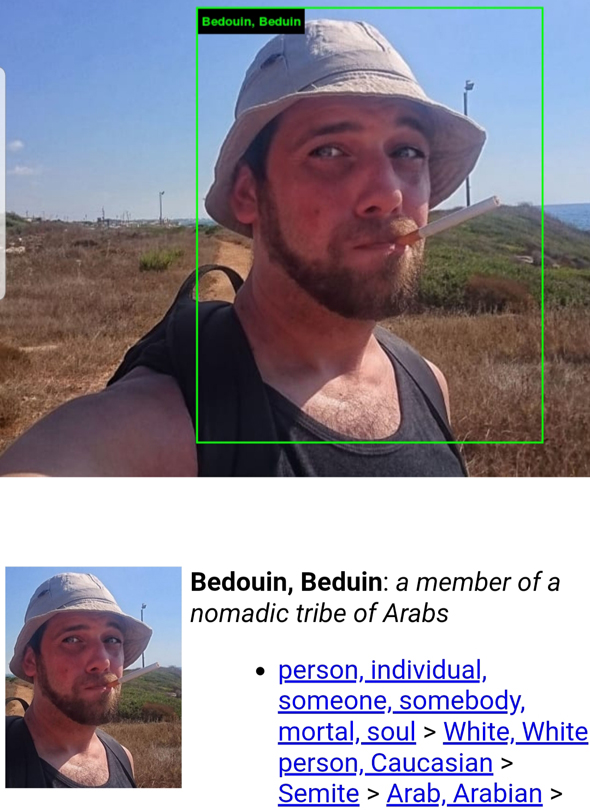

כשהצגתי את התמונה הזאת, קיבלתי תוצאה אחרת: בדואי. אולי הסיגריה, והעובדה שאני גם עם כובע וגם בשמש? לא ברור. אבל התוכנה פסקה "בדואי" וזהו.

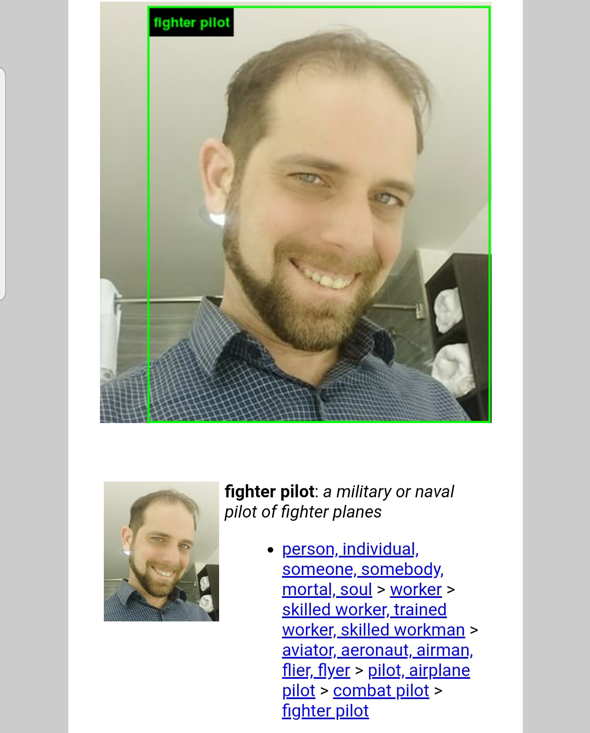

וכשהצגתי את זו, החליט האלגוריתם שלפניו טייס קרב. לא אתעמק בעבר הצבאי שלי, אך בואו נאמר שאי אפשר לדעת עליו משהו רק מלהסתכל על תמונה אקראית.

ואולם, חישבו על מה שעושה הקיטלוג הזה כשהאלגוריתם הוא שמנחה אנשים כיצד להתייחס למסכנים שמופיעים בתמונה. קיטלוג שנוגע לאוריינטציה המינית של אדם יכול להשפיע על הנכונות לקבל אותו לעבודה, ובמדינות מסוימות אף יכול להביא למעצר ורדיפה. קיטלוג שנוגע לעיסוק בהקשר צבאי עלול להגדיר תייר תמים כחשוד בריגול או בפעילות חתרנית, ובמדינות קסנופוביות ואיסלאמופוביות, קיטלוג כבדואי יכול לבשר רעות. ואלו הן רק שלוש דוגמאות, כולן מאוד סולידיות; מה עם אדם שיקוטלג כפושע, רק בגלל צבעו והעובדה שבתמונה היה לו מבט כעוס?

כשהצגתי תמונה מפורסמת למדי של ברט ריינולדס, קבע האלגוריתם שמדובר ב"מהפכן"; את ביל גייטס הוא הגדיר כ"גיק אקסצנטרי, אדם משונה", את אדולף היטלר כ"בן אצולה" ועוד. התוכנה פשוט הצמידה קיטלוגי אופי והתנהגות לתמונות, בלי שום קשר לעובדות. למשל, חלק מהתמונות שהעליתי אליה - בעיקר של מפורסמים למיניהם - קיבלו קיטלוג כמו "שטופת-זימה", "פסיכי" ועוד.

המיזם התפרסם במסגרת תערוכת Training Humans שמוצגת כיום במוזיאון פונדציון פראדה במילאנו. היא כוללת כמה דוגמאות מטרידות, למשל תמונה של הנשיא לשעבר ברק אובמה, בה הגדירה אותו התוכנה כקלפן. המסר שלה חזק וברור: אלגוריתמים שנבנו על בסיס קיטלוגים גזעניים, מיזוגניים, חשוכים או מוטים אחרת ינציחו את התפיסות הללו בקנה מידה נרחב - ויחזקו את הסטריאוטיפים והשפעתם.