הבוט שלי גזען: איך מגינים על מערכות בינה מלאכותית מדעות הקדומות?

השימוש הגובר בבוטים ובכלי בינה מלאכותית מושך את תשומת הלב לאופן שבו המערכות הללו עלולות לשכפל הטיות בעייתיות כמו גזענות וסקסיזם. איך מתכנתים AI שמתעלה על הדעות הקדומות של יוצריו?

הכל התחיל עם אלייזה, ילידת שנות השישים. אלייזה לא היתה אדם אמיתי אלא צ'טבוט, כנראה הצ'טבוט הראשון אי פעם, שפותח על ידי ג'וזף וייצנבאום מ־MIT. במובנים של היום אלייזה (ELIZA) לא היתה צ'טבוט מתקדם, ולדברי וייצנבאום תפקדה כפרודיה לתגובות של פסיכיאטרים במהלך טיפול. אבל היא קבעה תקדים משמעותי שתקף גם כיום: צ'טבוטים נותני שירות הם כמעט תמיד נשים. בין אם מדובר בעוזרות חכמות כמו סירי של אפל, קורטונה של מיקרוסופט ואלקסה של אפל או בדמויות בדיוניות כמו המחשב ב"מסע בין כוכבים: הדור הבא", שדיבר בקולה של השחקנית מייג'ל בארט.

ההסברים ל"נשיות" הזו נעים מטענות שמחקרים הצביעו על כך שלמשתמשים קל יותר לתקשר עם דמות נשית, ועד לטענה שמאחורי פיתוח הצ'טבוטים עומדים לרוב מפתחים גברים שלא טרחו לחשוב על הסוגיה לעומק. עד לאחרונה הנטייה הזו והטיות חברתיות נוספות שמוטמעות בתוך שירותים מקוונים לא זכו לתשומת לב רבה במיוחד. אך עתה, עם ניסיונן של חברות הטכנולוגיה לקדם את השימוש בצ'טבוטים, הסוגיה מובאת לקדמת הבמה.

"המפתחים חייבים להתייחס לסוגיות האלו בעבודתם", אומר דן פאלמר ממכון התקנים הבריטי (British Standards Institution, או BSI), שפרסם לאחרונה מדריך מקיף לפיתוח אתי של רובוטים ומערכות בינה מלאכותית (AI). לא מדובר במסמך הראשון שעוסק באתיקה של AI. קדמו לו בראש ובראשונה שלושת חוקי הרובוטיקה של אסימוב.

"המדריך משתמש בעקרונות של אסימוב כנקודת מוצא", מסביר פאלמר, "אבל ככל שהשימוש ברובוטים וב־AI עולה, נוצרות נסיבות ספציפיות שלא כוסו ולכן צריך לקיים דיון פרטני יותר. יש עלייה בחשש הציבורי סביב סוגיות כמו שימוש ברובוטים והחלפת אנשים ברובוטים. יש יותר ויותר מקרים שבהם מפותחים רובוטים לטיפול באנשים או מערכות AI שאוספות מידע מהרשת. השימוש ברובוטים ובבינה מלאכותית רק יגדל, ואנחנו צריכים לחשוב על ההשלכות".

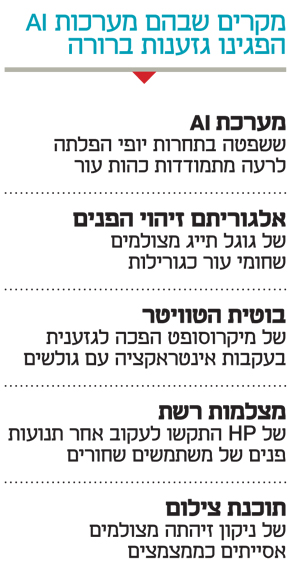

המדריך של ה־BSI מתייחס גם לאפשרות של יצירת רובוטים סקסיקטיים או גזעניים, שבאופן מטריד קרובה מתמיד. בשנה האחרונה התפרסמו מספר מקרים שבהם בוטים או מערכות AI הפגינו נטיות גזעניות: החל מבוטית הטוויטר של מיקרוסופט, שפיתחה אישיות גזענית בתוך יום פעילות בודד בעקבות האינטראקציה שניהלה עם הגולשים בשירות; דרך מערכת AI ששפטה בתחרות יופי והפלתה לרעה מתמודדות כהות עור; וכלה באלגוריתם זיהוי פנים של גוגל שפשוט תייג מצולמים שחורים כ"גורילות".

הדוגמאות הללו הן רק מקרי קיצון שבהם ברור שמשהו במערכת השתבש. מה שבאמת מטריד מפתחים וגורמים העוסקים בתחום הם המקרים שבהם הגזענות והסקסיזם הם חלק מהליך קבלת ההחלטות של המערכת הממוחשבת באופן שקשה לראות את תוצאותיה בפלט הסופי, והופך אותם לכמעט שקופים.

לא לגרום ל־AI לשכפל עשורים של טעויות

"הבעיה המדאיגה ביותר היא מערכות AI שמשתמשות בלמידת מכונה, כלומר שלומדת בעצמה על סמך קלט חיצוני. אם מערכת כזו רואה שרוב האסירים שחורים היא עלולה להסיק מכך שרוב השחורים הם פושעים", מחדדת את הסוגיה פרופ' ג'ואנה ברייסון מהאוניברסיטאות באת' ופרינסטון, שנחשבת לאחת החוקרות הראשונות בתחום האתיקה של בינה מלאכותית ורובוטיקה. ברייסון היא בעלת תואר ראשון במדעי ההתנהגות מאוניברסיטת שיקגו, תואר שני בבינה מלאכותית ותואר שני בפסיכולוגיה מאוניברסיטת אדינבורו ודוקטורט בבינה מלאכותית מ־MIT.

"ה־AI לא רואה את הסיבות והרקע שגרמו לכך שהאנשים נמצאים בכלא", היא מפרטת. "הבית הלבן הצהיר שהוא לא רוצה שלמידת מכונה תצלם את החברה כמו שהיא עכשיו, כשהיא משקפת עשרות שנים של החלטות רעות, ותקבע החלטות עתידיות לפי זה. בינה מלאכותית מתקדמת במהירות גדולה, כי לימדנו אותה לחקות את התרבות שלנו. אבל כשעושים את זה, היא קולטת גם הרבה דברים רעים ודעות קדומות".

עיצוב צ'טבוטים כנשים היא דוגמה בולטת לחיקוי בעייתי של המציאות, והיא לא מסתיימת בזהות המינית. "יש פער בין ההחלטה שבוט יהיה אישה לבין לשוות לאותה אישה התנהגויות סטיגמטיות וסקסיסטיות כמו פלירטוטים", אומר דרור אורן, מייסד ומנהל מוצר ב־Kasisto, שמפתחת בוטים ומערכות AI לתקשורת עם לקוחות עבור בנקים. "יש אפילו חברות שהופכות את המיניות הזו לאלמנט שיווקי, למשל הוצאת פרסומים על כמה פעמים הזמינו את הבוט שלהן לדייט".

כך באחת הפרסומות לסייעת הדיגיטלית של אפל סירי מחמיאה לשחקן ג'יימי פוקס ואומרת לו שהוא נשמע לה מושך במיוחד. יותר מכך, שאלות גבוליות זוכות לא פעם לתשובה פלרטטנית או כנועה. אם תשאלו את סירי Who’s your daddy? היא תשיב "אתה". אם תציעו לסירי נישואים, היא תענה שהיא לא מהסוג שמתחתן (Not the marrying kind), בעוד אלקסה תציע להישאר ידידים. קורטונה מצדה תשיב לשאלות מסוג זה באמירה הבעייתית "מכל השאלות שיכולת לשאול".

"אני לא חושב שיש כאן זדון, אלא ברירת מחדל", מסביר אורן מדוע לדעתו אפל והחברות שהלכו בעקבותיה בחרו להעניק לסייענים שלהן מגדר נשי. "אנשים לא ישבו וחשבו מה הדבר הנכון לעשות, אלא פשוט עשו מה שנראה להם הגיוני מאיך שהם מכירים את עצמם. אבל אחד הדברים שאנחנו יכולים לעשות כחברה שבונה את התחום זה לעצור שנייה ולחשוב".

"שאלת האחריות מאוד מורכבת", מרחיבה ברייסון. "יש הסבורים שמתכנתים צריכים לעבור הכשרה שתאפשר להם לזהות מצבים שעלולים להוביל לדעה קדומה. אבל גם החברות ששוכרות את המפתחים ומאשרות את שיווק המוצרים צריכות לקבל על עצמן אחריות. יש רמות שונות של אחריות, וחשוב שכל הגורמים יישאו בה. אי אפשר להאשים אדם אחד ולפטור את שאר הארגון מאחריות. העובדה שאנשים מאנישים מכונות עלולה להתברר כמסוכנת, כי אז קל להאשים את המכונה. אבל מדובר בחפץ שאנחנו בנינו ואנחנו אחראים עליו".

השפעה שלילית על חיי אנשים רבים

עבור רוב האנשים בינה מלאכותית מסתכמת בעוזרות חכמות כמו סירי או קורטונה, לא משהו שמשפיע על החיים השוטפים באופן משמעותי. אך ברייסון רואה את הכנסת הדעות הקדומות אל תוך ה־AI כבעיה רחבה הרבה יותר על רקע החדירה הגוברת של מערכות מסוג זה לתפקידים של סיוע בקבלת החלטות בקרב רשויות החוק והמשפט. למקרים כאלו עלולה להיות השפעה שלילית על חיים של אנשים רבים.

"מפחיד ששופטים מסתמכים על המלצות של מערכות AI בקביעת עונשים", היא אומרת, "אך מדובר גם בדברים יומיומיים יותר, כמו מערכת שאומרת לאובר לאן כדאי לשלוח רכב, מערכות שממליצות באילו תשתיות להשקיע או קובעות לאיזו שיחה יש לענות קודם במקרה של עומס על מוקד משטרה. יש מקרים רבים שבהם דעה קדומה יכולה להשפיע בלי שנשים לב אפילו".

ברייסון חוששת במיוחד ממקרים שבהם דעות קדומות משפיעות על מערכות בינה מלאכותית שעוסקות בתרגום שפות, כמו שירות התרגום של גוגל. "המערכת עלולה להוסיף מידע או דעות קדומות שלא נכללו בטקסט המקורי", היא מסבירה. באנגלית למשל מרבית השפה לא כוללת זכר ונקבה. כך משפט כמו I went to the Doctor עלול להיות מתורגם ל"הלכתי לרופא", אף שבמקור הכוונה היתה "הלכתי לרופאה".

איך אפשר להגן על האלגוריתם מדעות קדומות?

"יש תחום מחקר שמתמקד בחיפוש אחר דפוסים שמעידים על תמרון כזה של בינה מלאכותית. אפשר ליצור מערכת שתזהה אם מדובר במידע אמיתי או במישהו שמנסה להחדיר מידע מוטה. אין מה לעשות חוץ מלגלות ערנות, להיות מודעים לנושא ולנסות לזהות ולמנוע התערבות שכזו. כך למשל מיקרוסופט יכלה לנקוט צעדים מסוימים על מנת למנוע את הפיכת הצ'טבוט שלה Tay לגזענית בעקבות השיחה עם משתמשי טוויטר. מפתחי צ'טבוטים אחרים למשל יצרו רשימות שחורות של מילים שאם הופיעו בציוץ הבוט שלהם קיבל הוראה להתעלם ממנו.

"אין פתרון מושלם וחשוב שמפתחים תמיד ישמרו על ערנות ויבנו מערכות גמישות שיכולות להתמודד עם בעיות שונות. אבל צריך להבין גם שזו לא רק בעיה של המפתחים. כל החברה אחראית: הדירקטוריון, המנכ"ל, הסמנכ"לים, כולם צריכים לחשוב על ההשלכות האתיות ואם יש גילוי של דעה קדומה".

בוט נטול מגדר שמאפשר לכל משתמש לחוש בנוח

ב־Kasisto הניסיון להתמודד עם האחריות של עיצוב AI הוביל לבחירה לא להעניק מגדר לבוט שפיתחה החברה, ושמכונה קאי. "לפני שחשפנו את קאי לציבור עצרנו ושאלנו את עצמנו אם זה הגיוני שחבורת מתכנתים גברים תהיה בכלל זו שבונה את הדיאלוג של הבוט", מספר אורן. "החלטנו לשכור את ג'קלין פלדמן, בוגרת ייל עם תואר בספרות אנגלית שכתבה לברודווי, כדי שתעזור לנו לכתוב את הדיאלוג. לא רצינו שקאי ישקף את הדיאלוגים שיש לנו בין המתכנתים במשרד, אלא את אלו שצריכים להיות בין לקוח לבין בנק.

"הדבר הראשון שג'קלין עשתה היה להגדיר מה תהיה האישיות של קאי: מי זה, מה הוא, מה האופי שלו, האם הוא באטלר או עוזר אישי, חכם בלילה שיודע הכל או מישהו שנמצא ברמה של המשתמש מבחינת ההבנה. יצרנו פרסונה שלמה שלא קשורה רק למגדר, אלא לדברים רבים אחרים. כחלק מזה נוצרה ההבנה שאנחנו לא רוצים לקשור את קאי למגדר ספציפי, כי אנחנו רוצים שכולם ירגישו בנוח, גברים ונשים כאחד".

כשהשקתם את קאי היה בכלל מישהו ששם לב שאין לו מגדר?

"אישיות היא משהו מאוד חשוב ללקוחות שלנו כי הבוט מבטא את הערכים של הבנק, ואת הצורה שבה הבנק מתקשר עם לקוחות. כשאנחנו מתחילים לעבוד עם בנק, אחת השיחות הראשונות היא איזו אישיות אתם רוצים. גם העניין של המגדר הוא משהו שעולה. זה לא שאנחנו מתנגדים למגדר. זה בסדר שבוט יהיה אישה, אבל זה לא חייב להיות ברירת מחדל או מלווה בתכונות סטיגמטיות נשיות. בוט יכול להיות אישה מקצועית וחכמה שלא מפלרטת. תעשיית הבוטים מתפתחת מול עינינו. אם החברות הגדולות יהיו מודעות לזה, הן יוכלו להשפיע על האופן שבו אנשים תופסים סטיגמות. הסטיגמות קיימות, אבל אנחנו לא חייבים לחזק אותן. אנחנו יכולים לעזור לפוגג אותן".