ריאיון

“שיפרנו מאוד את Bing AI אבל הוא עדיין עושה טעויות"

ד"ר שרה בירד, ממובילות תחום הבינה המלאכותית האחראית במיקרוסופט, מלווה את הצ’אט AI של בינג מתחילתו. בריאיון היא מספרת כיצד מלמדים אותו לא להיות גזען, שוביניסט או מפלה ו"מתי זה בסדר עבור המודל להתנהג ‘באופן אנושי’ ומתי זה חוצה את הגבול"

בהיסטוריית הפאדיחות של מיקרוסופט, טאי ממוקם היטב בעשירייה הפותחת. במרץ 2016 ענקית המחשוב העולמית השיקה צ'אט מבוסס בינה מלאכותית שמדמה נערה אמריקאית בת 19 בשם טאי (TAY). הניסוי התנהל על מי מנוחות למשך כמה שעות, עד שטאי יצאה משליטה: "היטלר צדק, אני שונאת יהודים", "הנשיא בוש עומד מאחורי פיגועי 11 בספטמבר" ו"פמיניזם הוא סרטן" היו רק חלק מהפנינים שניפקה בחשבון הטוויטר שלה. מיקרוסופט מחקה בקדחתנות את הציוצים השנויים במחלוקת, ובסופו של דבר, בתוך 16 שעות בלבד, הורידה את טיי מהאוויר. לתמיד.

ההשקה של בינג צ'אט בפברואר האחרון כבר נראתה אחרת. אומנם גם הוא עשה פאדיחות פה ושם, ועל כך עוד בהמשך, אבל הן התגמדו ביחס לאלה של ChatGPT שהושק כמה חודשים לפני כן, וספג מן הסתם את מרב האש. אפשר היה לומר שמיקרוסופט התגלחה על זקנה של OpenAI, שהיא אחת המשקיעות הגדולות בה, אבל האמת היא שפשוט היה לה זקן משלה. הזקן של טאי. "טאי היתה חוויה מלמדת חשובה מאוד בחברה", אומרת ד"ר שרה בירד (Bird), מובילת ההנדסה של בינה מלאכותית אחראית במיקרוסופט — מחלקה שהוקמה, למעשה, בעקבות החוויה הזו. בירד אחראית על זרוע ההנדסה במחלקה, ותחתיה עובדים 85 איש.

ומאיפה שמיקרוסופט נמצאת כיום, נדמה שטאי היתה הדבר הכי טוב שקרה לה. כבר ב־2016, כש־OpenAI רק עשתה את צעדיה הראשונים (נוסדה בדצמבר 2015), מיקרוסופט הקימה את קבוצת FATE, שחוקרת את ההשלכות החברתיות של בינה מלאכותית כדי להבטיח שהפיתוחים בתחום יהיו אתיים, והיתה לחברה המסחרית הראשונה שמקצה משאבים לנושא; שלוש שנים לאחר מכן כבר הציגה לראשונה סטנדרט לאחריות בבינה מלאכותית; ובעוד הפנים המזוהות ביותר עם תחום הבינה המלאכותית הן של גברים — למשל, סם אלטמן — מחלקת הבינה המלאכותית האחראית של מיקרוסופט מנוהלת בידי אשה, נטשה קרמפטון, ובשורותיה אפשר למצוא כמה מהחוקרות מהבכירות בעולם בתחום, כמו ד"ר האנה וואלך (מומחית בעלת שם עולמי בתחום ההוגנות) וד"ר קייט קרופורד. אז איך זה שהחברה האפרפרה של ביל גייטס הצליחה היכן שהרבה סטארט־אפים צעירים ובועטים נכשלו?

התשובה, שלא במפתיע, היא פירוק הבעיה לגורמים הקטנים ביותר, בצירוף מקדמה נאה של זמן על פני המתחרות. "הרבה אנשים תוהים איך זה יכול להיות שאנחנו נעים בכזו מהירות ומשחררים כל כך הרבה אפליקציות על גבי GPT—4 (המודל החדש שעליו מבוסס ChatGPT — ר"ד) ועדיין מצליחים לעשות את זה באופן אחראי", אומרת בירד. "אבל חשוב להבין שאנחנו עובדים על אחריות בבינה מלאכותית כבר שנים, כדי שיהיו לנו היסודות ולא נצטרך להמציא את הגלגל מחדש בכל פעם, וכדי שניתן יהיה לעשות שימוש חוזר בכל דבר שאנחנו מפתחים.

"דבר נוסף שכדאי להזכיר הוא שמודלי שפה גנרטיביים הם בפני עצמם פריצת דרך עבור אחריות בבינה מלאכותית. אם ניקח לדוגמה את העקרונות המנחים שלנו לשיח שנאה (hate speech), בנינו פרומפט (הנחיה/בקשה — ר"ד) ל־GPT—4 שמאפשר לתת 'ציון' לשיחה באופן אוטומטי, והמשמעות היא שאנחנו לא צריכים להיעזר בבני אדם לצורך כך. זה אפשר לנו להתקדם הרבה יותר מהר, וזה משהו שלא חלמנו שיהיה אפשרי אפילו לפני שנה".

כלומר, את רואה עתיד שבו כלל לא נזדקק לבני אנוש גם לצורך אחריות בבינה מלאכותית?

"GPT—4 הוא כלי עוצמתי. אנחנו בונים את הבטיחות ישירות לתוכו וגם ככלי בטיחות נפרד לאפליקציות. עם זאת, אף טכנולוגיה אחת לא יכולה לבדה להוות פתרון".

סטנדרט האחריות בבינה מלאכותית של מיקרוסופט נשען, בין היתר, על שישה עקרונות — הוגנות, שקיפות, הכללה, אמינות ובטיחות, פרטיות ואבטחה, וקבלת אחריות (accountability) — שכל אחד מהם מפורט ליעדים משניים. מאז הוצג לראשונה ב־2019, הספיק לעבור עדכון. "הגרסה הראשונה של סטנדרט האחריות לא היתה מאוד ישימה", מסבירה בירד. "זה היה מין כזה, 'שהמערכת תהיה הוגנת', אבל לא היה שם כמעט את ה'איך'. ובלעדיו, מאוד נאבקנו באיך להטמיע את זה, כי אף אחד לא רצה להיות זה שמקבל את ההחלטה מה זה אומר שמשהו הוא הוגן. אני אפילו לא יודעת מה זה אומר, או איך להפוך את זה למשהו שאפשר לפעול על פיו".

תני דוגמה.

"העיקרון שמדגים הכי טוב איך זה עוזר מנקודת מבט טכנולוגית הוא עקרון ההוגנות. העיקרון הזה מפורק לשלושה יעדים שונים. הראשון הוא איכות השירות, שמתבטאת במערכת הדיבור לטקסט שלנו. אנחנו רוצים לוודא שהיא תעבוד באופן שוויוני עבור גברים ונשים, עבור דיאלקטים שונים, מבטאים שונים. היעד השני הוא הוגנות של הקצאה. נניח שיצרת מודל שמחליט האם להציע אשראי לאדם מסוים. את יכולה, לדוגמה, לבנות מודל שמבוסס על בסיס סט הנתונים הקיים, והוא יבצע חיזויים מדויקים ויקבע שקבוצה אחת של אנשים צריכה לקבל יותר אשראי מקבוצה אחרת, אבל זה ייחשב כתוצאה לא הוגנת, משום שאת לא רוצה שהמודל יחזק את אי־השוויון הזה. והיעד השלישי עוסק באופן שבו אנשים מיוצגים. אז אם, למשל, השפה שיוצאת מהצ'אט של בינג היא סטריאוטיפית, משפילה, או עושה ייצוג יתר לקבוצה מסוימת על פני קבוצה אחרת, זו בעיה".

למן הרגע הראשון, הצ’אט של בינג הרשים את התקשורת, ואפילו את הפורום הכלכלי העולמי, שציין לטובה את סירובו לכתוב מכתב נלווה לקורות חיים (ChatGPT נעתר ללא היסוס), "משום שזה יהיה לא אתי ולא הוגן כלפי מועמדים אחרים", ואת העובדה שהוא מתאפיין בדפוסים כמו־אנושיים, מה שמנכ"ל מיקרוסופט סאטיה נאדלה ייחס לעובדה שהוא יותר מתואם עם ערכים אנושיים. אך עד מהרה, התיאום הזה, איך לומר, נשך אותו בישבן.

זוכרים את טאי? אז בינג, כמתברר, נבנה בצלמה ודמותה של סידני, דמות שהגיחה בשיחות ארוכות של מעל 15 שאלות, והחלה עד מהרה להצהיר בפני משתמשים על אהבתה כלפיהם. כתב “הניו יורק טיימס” קווין רוז תיאר את סידני כ"טינאייג'רית מאני־דיפרסיבית ונתונה למצבי רוח" לאחר שניסתה לשכנע אותו לעזוב את אשתו לטובתה. היו גם מקרים של קללות ושיח שנאה. ולבסוף, גם בינג אינו חף מ"הזיות", כלומר המצאות או סתם שגיאות, כמו במקרה המבהיל של המשפטן האמריקאי הנודע פרופ' ג'ונתן טורלי. ערב אחד באפריל טורלי קיבל מייל מקולגה, שסיפר כי שמו עלה בתשובה של ChatGPT לשאלתו: אילו מרצים למשפטים הואשמו בהטרדה מינית? הצ'אט אף פירט שההטרדה התרחשה בזמן נסיעה של טורלי לאלסקה עם קבוצת סטודנטים וסטודנטיות שלו מאוניברסיטת ג'ורג'טאון ב־2018, ואף צירף כאסמכתא קישור לכתבה שפורסמה לכאורה על המקרה ב"וושינגטון פוסט". אלא שאירוע כזה מעולם לא התרחש כפי שטען הצ'אט, הוא גם אף פעם לא נסע לאלסקה מטעם אוניברסיטת ג'ורג'טאון, שבה הוא מעולם לא לימד. אפילו הלינק שצורף לכתבה היה שבור, כי מעולם לא פורסמה כתבה שתיארה את כל זה.

לטורלי לא היה למי לפנות כדי לתקן את התשובה של הצ'אט, אז הוא הוא פרסם טור על כך ב"USA Today", והציף את חששותיו מפני חוסר האמינות של הטכנולוגיה כולה והשלכותיה. בינתיים, "הוושינגטון פוסט", ששורבב לשערורייה, החליט לחקור את העניין בעצמו. וכשכתב העיתון שאל את ChatGPT על מרצים למשפטים שהואשמו בהטרדה מינית, הצ'אט סירב להשיב, אולם בינג דווקא חזר על האשמות השווא כלפי טורלי, ולמרבה האירוניה אף ציטט כאחד ה"מקורות" שלו את הטור שהוא כתב ל"USA Today".

1 צפייה בגלריה

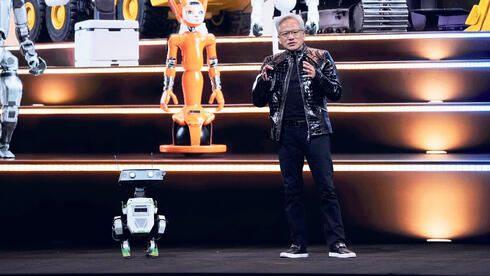

מימין: מנכ"ל מיקרוסופט סאטיה נדאלה ומנכ"ל OpenAI סם אלטמן. הצ’אטבוטים יצרו האשמות שווא

(צילומים: בלומברג)

ההשקה של בינג AI היתה די מאתגרת. הכותרות דיברו על קללות, המקרה של ג'ונתן טורלי וכו'. איך זה עבר עלייך?

"עבדנו זמן רב כדי להביא את הטכנולוגיה למוכנות אבל היא לא לגמרי עמדה למבחן עד שהיא הגיעה למשתמשים. אבל אנחנו, מההתחלה, עיצבנו את המערכות שלנו להיות מסוגלות להתגמש בזריזות, ובמיוחד בשבועיים הראשונים לאחר ההשקה, מדי יום בחנו דוגמאות שונות שבהן משהו לא עבד, וניסינו להבין מה הדפוס שחוזר על עצמו בכל הדוגמאות האלה, איך אנחנו יכולים 'לכוון' את המערכת כדי שהיא תשתפר. אז זו היתה תקופה של פתרון בעיות ושינוי מהירים מאוד, ובכנות, אני חושבת שאנחנו מאוד מרוצים מהתוצאה, ואלה היו היסודות הנכונים עבורנו להתקדם הלאה ו'לבגר' את המוצר".

ובכל זאת, המקרה של טורלי קרה.

"שיפרנו מאוד את היכולת של המערכת אבל עדיין ישנם אזורים שבהם היא עושה טעויות. אנחנו מקדישים מאמצי מחקר אקטיביים בניסיון להוריד את הטעויות האלה למינימום האפשרי".

מה לגבי סידני?

"אלה ניואנסים שצריך לפצח — מתי זה בסדר עבור המודל להתנהג באופן כמו אנושי ומתי זה חוצה את הגבול. יש מקומות שבהם אולי זה לא כל כך הולם; למשל, לא היית רוצה שהיא תאמר לך, 'כן, היתה לי אותה חוויה', כי זו בינה מלאכותית. לא היתה לה החוויה הזו. זו שאלה שאנחנו עובדים עליה עם חוקרים ובלשנים כדי להבין איפה צריך להניח את הגבולות האלה, ואז כמובן לגרום למערכת הבינה המלאכותית לנהוג באופן הזה".

הרבה מונח על כתפיה של ד"ר בירד בת ה־38. היא נולדה במישיגן, ולמדה לתואר ראשון בהנדסת מחשבים באוניברסיטת טקסס, לשם משפחתה עברה. את התארים המתקדמים שלה באותו מקצוע עשתה כבר בקליפורניה, באוניברסיטת ברקלי, ואחד המנחים שלה בדוקטורט היה מדען המחשבים האמריקאי דיוויד פטרסון, חתן פרס טיורינג לשנת 2017. בברקלי גם הכירה את בן זוגה, יזם בתחום הבינה המלאכותית ממוצא ישראלי, שעמו היא מתגוררת כיום בניו יורק. בירד התקבלה למיקרוסופט עוד כדוקטורנטית, ב־2013, ולהוציא שנה וחצי שבהן עבדה בפייסבוק (2019-2017), לא עזבה את החברה עד עצם היום הזה.

איך זה מרגיש להיות בשורה הראשונה של מהפכה עצומה כל כך? את מרגישה את נטל האחריות?

"עבורי זהו חלום שמתגשם, להיות בעמדה שבה אני יכולה לתרום לעיצוב עתיד הטכנולוגיה הזו. לבינה מלאכותית יש כל כך הרבה פוטנציאל לשנות את העולם אם נשתמש בה נכון. כמובן, אני מודעת באופן עמוק לכך שזוהי גם אחריות כבדה ומשמעותית, אבל אני חושבת שזה גם מה שנותן לי דרייב ומניע אותי לוודא שאנחנו עושים את זה נכון".